| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- BFS

- dp

- 구글 킥스타트

- linux

- 네트워크

- DFS

- 리눅스

- AI

- nlp

- 운영체제

- PYTHON

- 프로그래밍

- 코딩 테스트

- google coding competition

- 백준

- 브루트포스

- 알고리즘

- 코딩

- kick start

- 프로그래머스

- 파이썬

- CSS

- 동적 프로그래밍

- OS

- 동적프로그래밍

- 킥스타트

- 순열

- 딥러닝

- 코딩테스트

- 그래프

- Today

- Total

오뚝이개발자

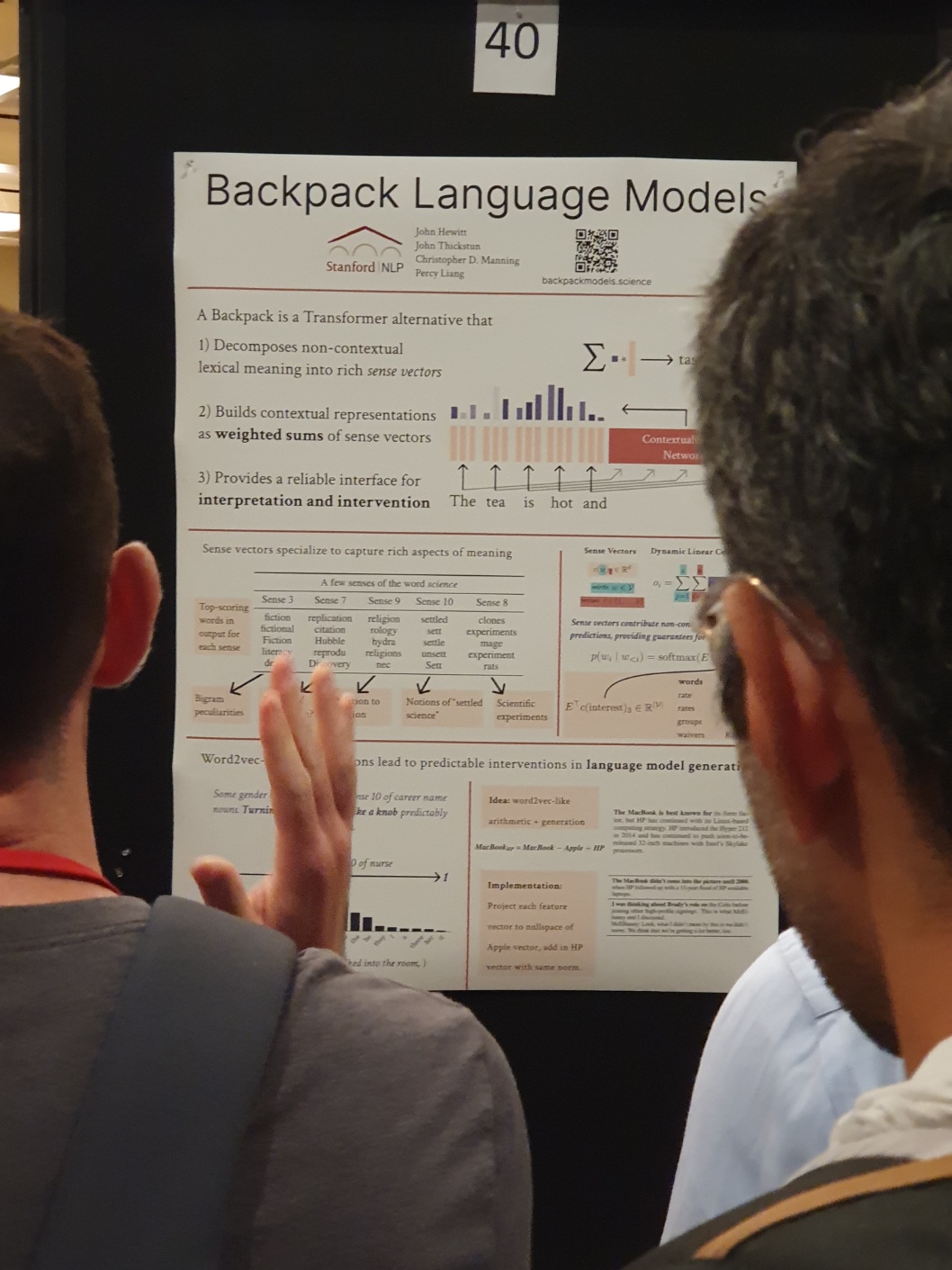

최신 NLP 연구 트렌드(ACL2023 회고록) 본문

캐나다 토론토에서 ACL2023이 개최되었다. 7월에 다녀왔는데 귀찮아서 미루고 미루다 한달이 지나서야 후기를 쓰는 나... 이러다간 내용 다 까먹어버릴까봐 무서워서 얼른 호다닥 쓴다 ㅋㅋㅋ(하...그나저나 캐나다 너무 좋았다...헤으응...또 가고싶...) 이 글에선 ACL2023에서 본 것들을 토대로 최신 NLP 연구 동향에 대해 소개해보고자 한다. 이번 학회에서는 굉장히 많은 토픽들이 다루어졌는데 그 중에서 사람들이 많이 몰리는 세션과 해당 주제로 많은 페이퍼가 나온 토픽과 이전에는 없었다가 새롭게 등장한 토픽들을 기준으로 선정하여 소개하고자 한다. 아무래도 그 세 가지 위주로 보는 것이 좀 더 유의미하지 않을까 싶다. 덧붙이자면 모든 토픽에 대해 세세하게 설명하기 보다는 그저 내가 보았던 것들 위주로 전반적인 경향을 가볍게 훑고 핵심을 언급하면서 설명할 것이다. 그러니 그냥 "아~ 이번 ACL 학회에서는 이러한 것들이 다루어졌구나~"하는 정도로 가볍게 보면 될 것 같다.

Large Language Model (LLM)

ChatGPT와 함께 LLM 분야가 많은 각광을 받고 있다. 이번 학회에서도 역시 많은 페이퍼들이 나왔다. 새로운 LLM을 제안하는 페이퍼들도 정말 많았고, 이러한 LLM을 다양하게 활용하는 방법들에 대한 주제들도 많았다. 예컨대, human evaluation을 LLM으로 대체하거나 data labeling의 annotator로 사용하거나 혹은 LLM을 사용해 data augmentation을 하는 주제들도 많이 보였다. 눈여겨볼 부분은 LLM의 활용에 대한 주제들이 심심찮게 보였다는 점이다. LLM을 이용해 기존의 인간 노동력이 필요하던 작업이나 rule-based로 복잡하게 처리되던 작업들을 쉽고 빠르게 처리하려는 움직임이 보였다. 앞으로도 LLM 분야는 계속해서 많은 발전이 있을 것 같다.

Multilingual & Crosslingual

multilingual과 crosslingual과 관련된 세션에 사람들이 정말 많이 몰렸다. 오히려 conversational AI 세션보다도 더 많이 몰려서 놀랐다. 개인적인 생각으로는, LLM이 등장하고 어느 정도 좋은 성능들을 보이는 것이 알려졌으니 이것을 모든 언어에서 잘 작동하도록 해서 많은 사람들이 사용할 수 있게 하려는 움직임으로 생각된다. 어찌보면 당연한 것 같다. LLM의 학습데이터는 거의 대부분이 영어인 경우가 많다. multilingual model이라고 해도 영어에서의 성능이 가장 높게 나온다. 실제로 ChatGPT에게 같은 문맥의 질문을 영어와 한국어로 해서 비교해보면 답변의 퀄리티가 차이나는 경우가 종종 있다. 이처럼 데이터의 bias에 의한 성능상의 차이를 극복하려는 시도들이 많이 보였다.

그 외 부가적인 것으로는 multilingual과 crosslingual related topic이 관심을 끌면서 기존의 conventional task인 machine trainslation이 다시 각광을 받기 시작했다는 점이다. 또한 소수가 사용하는 언어들에 대한 데이터셋 구축과 같이 점차 linguistic diversity를 추구하려는 방향으로 나아가고 있다. 아! 참고로 한국어의 경우 multilingual dataset에서 타 언어 대비 굉장히 낮은 성능을 보인다....거의 일본어와 한국어가 성능 리포트에서 거의 밑바닥에 있었다...multilingual POS tagging task에선 영어와 비교해 한국어가 거의 20-30 정도의 스코어 차이가 났다. 아무래도 구축된 양질의 데이터셋이 영어 대비 적기도 하고, 형태소나 조사 같은 언어구조적인 복잡성 때문에 이러한 결과가 생긴 것 같다. 가까운 미래에 AI 기술에서의 격차를 줄이려면 우리 나라에서의 자체적인 한국어AI에 대한 연구가 많이 이루어져야 할 것 같다. 기본적으로 ChatGPT와 같이 영어로 학습한 지식을 기반으로 한 답변을 한국어로 번역해 알려주는 시스템은 한국어 고유의 특징을 반영할 수 없기 때문이다(예컨대, 높임말 같은 politeness). 실제로 그 나라의 언어는 그 나라의 문화를 반영한다는 생각으로 언어와 문화 간의 correlation을 수치적으로 분석하려는 토픽도 보았다.

More Human-like AI

이제는 단순히 기계적인 AI를 넘어서 좀 더 사람같은 AI 시스템을 만드는 것 또한 중요해졌다. 이와 같은 맥락에서 이번 학회에서도 human-like AI에 대한 주제들이 많이 보였다. speaker intention detection이라고 해서 단순히 user의 질문에 답변만 하는 것이 아니라 화자의 의도를 분석해서 답변을 하는 연구들이 있었다.

또한, LLM의 등장으로 model이 수행해야 할 task들이 점차 복잡, 다양해지고 있다. conventional task들처럼 format이 항상 일정하지도 않고, 단순히 정답 label로 학습만 한다고 해서 맞추기 어려운 문제들이 등장하고 있다. 이에 따라 기존의 단순한 task들(ex. classification, regression)보다 훨씬 복잡한 reasoning과 같은 task에서 좋은 성능을 내기 위한 연구들이 많았다. 음....아 그리고 흥미로웠던 건 humor를 이해하는 LLM에 대한 연구도 있었다 ㅋㅋㅋ(재밌어보여서 듣고 싶었는데 해당 포스터에 사람들이 너무 많이 몰려서 보지를 못했다 ㅜㅜ)

Moral & Ethics in AI

AI에서 윤리나 도덕과 관련된 문제들이 야기되면서 해당 주제 관련 페이퍼들이 많이 보였다. 아예 해당 세션이 따로 있을 정도였다. 아무래도 요즘 가장 핫한 주제인만큼 이쪽 세션에도 사람들이 정말 많이 몰렸다. 학계에서도 공통된 의견 중 하나는 요즘 들어 빅테크 기업들이 AI reasearch 분야에서 거의 독점적으로 연구를 이끌어가고 있다는 것이었다. 관련해서 통계적으로 분석한 페이퍼도 이번 학회에 있었다. AI 분야는 computing resource 때문에 어쩔 수 없이 돈과 맞물려 발전하게 되어있고, 모델이 점차 커짐에 따라 이렇나 격차는 더 가속화 되어가고 있다. 때문에 이제는 대학 레벨에서 할 수 있는 연구와 기업 레벨에서 할 수 있는 연구가 점차 나뉘어지고 있는 실정이다. (사실 연구실에서 교수님과 선후배들과 이러한 이야기를 정말 많이 나누었는데...세계적으로 다들 비슷하게 느끼고 있는 것 같다) dataset에서의 bias에 대한 연구들도 많았다. language bias, gender bias나 social minority bias로 모델에 야기되는 문제들과 같은 것들.

Moral과 Ethic 관련된 주제의 페이퍼들이 많이 나오는 이유는 아무래도 이제 어느 정도 AI의 발전이 saturated되었다는 생각에서 비롯된 것 같다. 예컨대, 우리나라도 60년대에는 맹목적인 목표지향적 경제 성장이 목표였지만 그 목표를 어느 정도 이루고 나자 웰빙, 워라밸과 같은 단어들이 등장하였다. 이처럼 모든 기술의 발전은 처음엔 성능 지향적(performance-oriented)인 발전이 주를 이루다가 어느 순간 가치 지향적(value-oriented)인 발전으로 옮겨가게 되어있다. 아마도 그러한 맥락에서 도덕이나 윤리와 관련된 주제들이 각광을 받는게 아닐까 싶다.

Parameter Efficient Training Method

PEFT(Parameter Efficient Fine Tuning)과 같이 training cost를 획기적으로 줄일 수 있는 기법들에 대한 연구가 이번 학회에서 많이 보였다. 아무래도 모델이 점차 거대화되어 가고 있는 시점에 실질적, 경제적인 차원에서 중요한 문제가 되어서 그런 것 같다. 얼마 전 학교에 방문한 한 환경공학 교수님의 특강에서 들었는데 AI가 등장하면서 데이터센터 같은 곳의 서버GPU 때문에 탄소배출량이 증가하였고, 실제로 이것이 점점 더 증가하고 있는 추세라고 한다. 비단 이런 이유 뿐만 아니라 실제로 요즘 등장하는 거대 모델들은 그 엄청난 파라미터 수 때문에 학습시키는데 몇 시간 단위가 아닌 몇일 길게는 한 두달까지의 시간이 걸리기도 한다. 이러한 비효율적인 문제를 해결하기 위해서라도 Parameter Efficient Training Method에 대한 연구가 필요한 것 같다.

NLP + Health care

NLP와 health care를 접목한 페이퍼들도 전과 달리 많이 보였다. 이것도 아예 하나의 세션이 따로 마련되어 있어서 health care 분야에서 NLP를 접목한 페이퍼들을 묶어서 설명하기도 하였다. 내가 보았던 주제들은 상담사와의 메신저 히스토리를 데이터로 사용해 mental disorder를 detection하는 것과 mental care에 도움을 주는 챗봇에 대한 연구였다. 아무래도 NLP 분야가 언어와 관련된 분야이다보니 주로 physical health보다는 말에서 드러나는 mental health 관련 연구들이 많은 것 같다. Health care분야는 AI에서도 예나 지금이나 정말 많은 관심을 받고 있는 분야인데, 먼 미래에 AI 닥터가 정말 실현될 수 있을지 나도 너무 궁금하다.

High quality generation

이제 LM은 단순한 문장을 generation하는 것을 넘어서 long story를 generation하기도 한다. 이처럼 점차 많은 양의 text generation을 수행함에 따라 좀 더 고도화된 generation을 하는 것이 중요해졌다. 짧은 단문보다 긴 글을 생성할 때에는 서두의 정보를 잊어버리거나 잘못된 문장을 생성할 확률이 더 높아지기 때문이다. 이에 따라 long text에서 coherence를 유지하도록 하는 method에 대한 연구가 등장하였다. 또한 open-ended text generation에서 단순한고 뻔한 응답보다는 좀 더 context를 잘 반영하고 consistent한 답변을 generation하는 연구도 있었다.

Evaluation

LLM과 instruction-following task의 등장으로 이제는 model이 수행해야하는 task들이 더 복잡해졌다. 예컨대, 개와 고양이를 구분하는 단순한 문제에서 지금은 "층간소음 경고문을 작성해줘", "여름철 발리 휴양지 10가지만 추천해줘"와 같은 고정되지 않은 양식의 task들을 수행해야만 한다. 이에 따라, 점점 복잡해지는 task들에 대한 evaluation method들에 대한 연구가 많이 등장하고 있다. 내 생각에 이러한 연구들은 대부분 두 가지 측면에서 이루어지는 것 같았다. 1)기존의 previous metric의 단점을 보완하는 metric 2)사람의 관점을 잘 반영하는 metric.

evaluation 분야도 앞으로 점점 더 많은 페이퍼들이 등장할 것으로 생각된다. 모델의 성능을 수치적으로 report할 수 있는 수단이고 학계도 점점 기존의 metric들이 현재 등장하는 모델들의 성능을 측정하기에 한계가 있다는 사실을 인지하고 있기 때문이다. 때문에 기존의 단순하고 단편적인 측면을 평가하는 automatic metric 대신 GPT4 evaluation을 많이 하기도 한다. 실제로 GPT4가 human evaluation을 대체할 수 있는지에 대한 페이퍼도 있었다.

Better Prompt Design

LLM의 등장으로 prompt의 중요성도 대두되고 있다. 실제로 prompt에 따라 모델이 생성하는 답변의 퀄리티가 달라지고 hallucination 같은 문제가 발생하기도 한다. 아무리 좋은 도구가 있더라도 제대로 사용할 수 있는 방법을 알아야 하는 것이다. 이에 따라 더 나은 prompt design 전략에 대한 페이퍼들이 많이 나왔다. 그 중 가장 많이 보였던 것은 Chain of Thought(CoT)였다. 간단히 말하자면, reasoning과 같은 복잡한 문제에서 인풋 프롬프트에 few-shot learning과 같이 예시를 주는 것이다. 이 때 예시에 해당 문제를 해결하는 논리적인 풀이 과정이 포함되어 있어야 한다. 그리고 마지막으로는 Let's think step by step이라는 trigger sentence를 넣어주는 것이다. 이러한 방식의 목적은 모델에게 단순히 답이 아닌 답을 도출해내는 과정을 학습시킨다는 것이다. 관련해서 더 자세한 내용은 카카오에서 정리해둔 링크를 참고하기 바란다.

'NLP' 카테고리의 다른 글

| OpenAI ChatGPT에 대한 소개와 능력 및 한계 (2) | 2023.02.08 |

|---|---|

| NLP 분야 Data augmentation (0) | 2022.05.28 |