| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- 네트워크

- 알고리즘

- nlp

- 코딩테스트

- 프로그래머스

- kick start

- 구글 킥스타트

- 순열

- 동적프로그래밍

- 코딩 테스트

- google coding competition

- 운영체제

- 백준

- dp

- CSS

- PYTHON

- 딥러닝

- 브루트포스

- 파이썬

- OS

- 리눅스

- 동적 프로그래밍

- 킥스타트

- AI

- 프로그래밍

- DFS

- 코딩

- 그래프

- BFS

- linux

- Today

- Total

목록AI/Deep Learning Paper Review (9)

오뚝이개발자

Forward-Forward Algorithm 논문 리뷰

Forward-Forward Algorithm 논문 리뷰

오늘 소개할 논문은 Geoffrey Hinton의 “The Forward-Forward Algorithm: Some Preliminary Investigations”이다. 2022 NIPS talk에서 다루어졌던 논문으로 22년 12월에 arXiv에 공개된 따끈따끈한 논문이다. 힌튼은 현재 딥러닝 학습의 근간을 이루는 역전파(Backpropagation) 알고리즘의 초기 연구에 참여했던 인물이다. Backpropagation(이하 BP)은 오늘날 여러 AI 모델들의 learning procedure에 사용되는 중요한 알고리즘이다. 하지만 컴퓨터 과학자이면서 인지심리학자이기도 한 힌튼은 실제 우리 대뇌 피질의 학습 과정이 BP와 유사하지 않다는 점을 지적하면서 새로운 Forward-Forward algor..

RepSum : Unsupervised Dialogue Summarization based on Replacement Strategy(ACL 2021) 논문 리뷰

RepSum : Unsupervised Dialogue Summarization based on Replacement Strategy(ACL 2021) 논문 리뷰

paper link : https://aclanthology.org/2021.acl-long.471.pdf Overview Dialogue summarization에서 일반적인 text summarization과 비교했을 때 어려운 점은 바로 training data가 부족하다는 것이다. 이 논문은 이러한 문제를 unsupervised 학습으로 해결하고자 시도하였다. 논문의 핵심 아이디어는 다음과 같다. Superior summary approximates a replacement of the original dialogue, and they are roughly equivalent for auxiliary tasks. 즉, 좋은 요약본은 원문의 데이터들을 충분히 가지고 있으므로 여러 task에서 원래의..

대화 요약 Multi-View Squence-to-Sequence Models with Conversational Structure for Abstractive Dialogue Summarization(2020 EMNLP) 논문 리뷰

대화 요약 Multi-View Squence-to-Sequence Models with Conversational Structure for Abstractive Dialogue Summarization(2020 EMNLP) 논문 리뷰

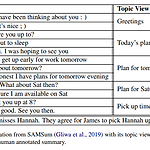

원논문 링크 : https://arxiv.org/pdf/2010.01672.pdf 본 논문은 dialogue summarization에서 multi-view seq-to-seq model을 제안한 논문이다. 핵심적인 내용으론 unstructured daily chat으로부터 다양한 관점에서의 conversational structure를 추출해 보다 정확한 대화 요약을 생성해낸다는 점이다. 본 모델은 automatic 그리고 human evaluation 모두에서 기존의 SOTA(State-Of-The-Art)를 능가하였다. Dialogue data set의 특징 dialogue data는 기존의 structured date와는 다른 특징을 갖고 있다. informal(사람 간의 chit-chat은 설명..

Towards a Human-like Open-Domain Chatbot(Meena) 리뷰

Towards a Human-like Open-Domain Chatbot(Meena) 리뷰

오늘 소개할 논문은 구글 리서치팀에서 발표한 "Towards a Human-like Open-Domain Chatbot"이다. (원논문 링크) Meena라는 이름으로 잘 알려진 2020년도 구글에서 발표한 챗봇에 관한 논문이다. 하지만 사실상 챗봇 모델보다는 evaluation metric을 제안했다는 것에 큰 의의가 있다. 본 논문의 핵심 1. Meena는 end-to-end로 학습된 multi-turn, open-domain 챗봇이다. 2. 다음 토큰의 ppl(perplexity)을 최소화하는 방식으로 학습 3. SSA라는 human evaluation metric을 제안 SSA는 Sensibleness and Specificity Average다. 한마디로, 말이 되는지(sensible) 그리고 g..

ELECTRA(ICLR 2020) 논문 리뷰

ELECTRA(ICLR 2020) 논문 리뷰

오늘 소개할 논문은 "ELECTRA: PRE-TRAINING TEXT ENCODERS AS DISCRIMINATORS RATHER THAN GENERATORS"이다.(원논문 링크) What is ELECTRA? ELECTRA는 구글 리서치 팀에서 발표한 논문으로 LM의 새로운 pre-training 기법을 제안하였다. ELECTRA는 Efficiently Learning an Encoder that Classifies Token Replacements Accurately의 약자이다. 기존의 MLM(Masked Language Model) 태스트를 통한 pre-training 방식은 많은 연산량을 필요로 한다. 이로 인해 충분한 컴퓨팅 리소스가 없는 연구자들에게 LM을 학습시키기가 점점 어려워지고 있다. ..

BERT(NAACL-HLT 2019) 논문 리뷰

BERT(NAACL-HLT 2019) 논문 리뷰

BERT 원논문 링크 What is BERT? Bidirectional Encoder Representations from Transformers Can be fine-tuned with jus one additional output layer for a wide range of task Don't need task-specific architecture Motive BERT는 left to right LM이 sentence level task에서 sub-optimal이라는 점을 지적 기존 LTR LM은 주로 양방향으로부터의 문맥정보를 incorporate하는 것이 중요한 경우 취약(e.g. question answering) Transformer에서 착안한 BERT Encoder Attention을 사..

Attention is all you need(NIPS 2017) 논문 리뷰

Attention is all you need(NIPS 2017) 논문 리뷰

오늘 리뷰할 논문은 구글 리서치팀에서 발표한 "Attention is all you need"(링크)이다. 해당 논문은 현대 NLP의 중요한 backbone으로 사용되는 Transformer에 관한 논문이다. 사실 원논문의 제목보다 Transformer라는 이름으로 더 많이 알려져 있다. NLP model history 그 동안 ML분야에선 vision과 관련된 분야들이 눈에 띄는 발전을 이루어 온 것에 비해 NLP 분야의 발전은 더딘 편이었다. 그러나 최근 들어 좋은 성능을 보이는 다양한 모델들이 나오면서 NLP 분야에서도 급진적인 발전이 이루어지고 있다. 이러한 NLP의 발전을 이끈 모델들의 변천사는 대략 아래와 같다. 오늘 리뷰할 Transformer 논문은 2017년에 발표된 것이다. What d..

NLG(Natural Language Generation)에 대하여

NLG(Natural Language Generation)에 대하여

Sub-tasks of NLG Machine Translation Summarization Dialogue : task-oriented system, open-domain system(social dialogue) Creative writing : storytelling, poetry-generation Freeform Question Answering Image captioning Language Model(LM) Language Modeling : 특정 time-step까지의 words sequence가 주어졌을 때, 해당 time-step 이후의 word를 predict하는 것 Language Model : 확률 분포 P(yt|y1,...,yt-1)를 producing하는 system Conditi..