300x250

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |

Tags

- nlp

- 동적 프로그래밍

- 알고리즘

- 리눅스

- 그래프

- PYTHON

- DFS

- 코딩

- CSS

- 코딩테스트

- 백준

- 네트워크

- 브루트포스

- dp

- 코딩 테스트

- 킥스타트

- 파이썬

- google coding competition

- 동적프로그래밍

- kick start

- 운영체제

- linux

- 구글 킥스타트

- BFS

- 순열

- OS

- 딥러닝

- 프로그래머스

- AI

- 프로그래밍

Archives

- Today

- Total

오뚝이개발자

Bias와 Variance 본문

728x90

300x250

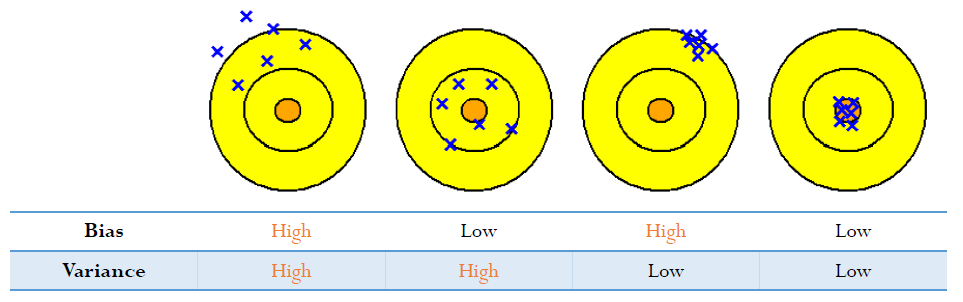

Bias와 Variace의 개념

쉽게 사격을 한다고 생각하면 된다. 위 그림의 파란색 엑스표는 예측값을 나타낸다. bias란 말그대로 예측값이 중앙(Truth)에서 얼마나 멀리 떨어져있는지를 나타낸다. bias가 높으면 중앙에서 멀리 떨어져있고, 낮으면 중앙과 가까이 붙어있다는 것이다. variance란 예측값들이 서로 얼마나 멀리 떨어져있는지를 나타낸다. variance가 높으면 예측값들이 서로 멀리 떨어져있고, 낮으면 서로 붙어있다.

성능과 bias, variance

- 모델의 성능을 높이기 위해선 당연하게도 bias와 variance를 둘 다 줄이는 것이 좋다.

- 하지만 이 둘 간에는 상충관계(trade-off)가 있다.

- 일반적으로 bias가 증가하더라도 variance의 감소폭이 크면 좋은 모델이라고 한다.

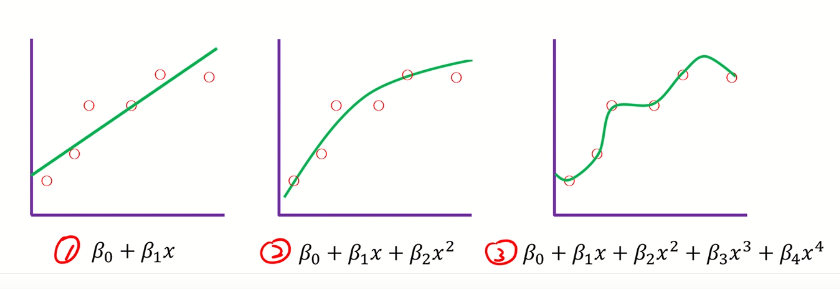

정규화(Regularization)와 bias, variance

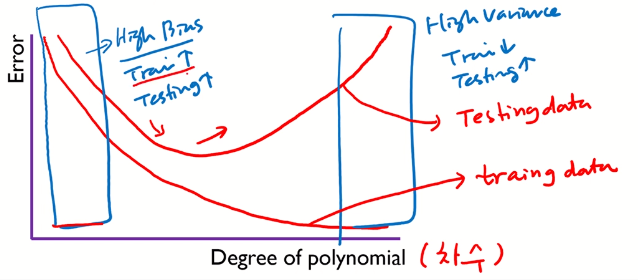

위 그래프는 차수가 높아질수록 모델이 데이터를 얼마나 잘 나타내는지를 보여준다.

위 그래프는 차수에 따른 오차를 보여준다. 빨간 선 두개 중 위쪽 선이 test data, 아래쪽 선이 train data를 나타낸다. 이를 bias와 variance관점에서 살펴보자. 차수가 낮을 땐, test와 train 모두 오차가 크다. 다시 말해 bias가 높다. 차수가 높을 땐, train 오차는 과적합에 의해 작아지지만 test 오차는 커진다. 다시 말해 variance가 높다.

728x90

300x250

'AI > 밑바닥딥러닝1' 카테고리의 다른 글

| [핸즈온ML] CH1. 한눈에 보는 머신러닝 (0) | 2020.07.13 |

|---|---|

| 선형회귀(linear regression), 라쏘(LASSO), 리지(Ridge) (0) | 2020.07.07 |

| L1, L2 regularization (0) | 2020.06.28 |

| 오버피팅(overfitting) 방지법 정리 (0) | 2020.06.27 |

| [CH8] 딥러닝 (0) | 2020.06.23 |

Comments